В компьютерной памяти , в стандартных уровнях RAID включают в себя базовый набор RAID ( « Избыточный массив независимых дисков „или“ избыточный массив недорогих дисков ») конфигурация , которые используют методы удаляющего , зеркальное отображение , или четности для создания больших надежных хранилищ данных из несколько универсальных компьютерных жестких дисков (HDD). Наиболее распространенными типами являются RAID 0 (чередование), RAID 1 (зеркалирование) и его варианты, RAID 5 (распределенная четность) и RAID 6 (двойная четность). Несколько уровней RAID также могут быть объединены или вложены, например RAID 10 (чередование зеркал) или RAID 01 (наборы чередующихся зеркал). Уровни RAID и связанные с ними форматы данных стандартизированы Промышленной ассоциацией сетей хранения данных (SNIA) в стандарте Common RAID Disk Drive Format (DDF). [1] Числовые значения служат только в качестве идентификаторов и не обозначают производительность, надежность, генерацию или какой-либо другой показатель.

Хотя большинство уровней RAID могут обеспечить хорошую защиту и восстановление после аппаратных дефектов или дефектных секторов / ошибок чтения ( серьезные ошибки ), они не обеспечивают никакой защиты от потери данных из-за катастрофических сбоев (пожар, вода) или программных ошибок, таких как ошибка пользователя. , сбой программного обеспечения или заражение вредоносным ПО. Для ценных данных RAID - это только один из строительных блоков более крупной схемы предотвращения потери данных и восстановления - он не может заменить план резервного копирования .

RAID 0 [ править ]

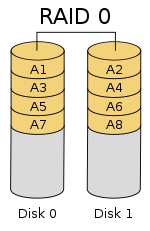

RAID - 0 (также известный как набор полосок или полосатый объема ) расщепляется ( « полосы данных равномерно по двум или более дисков»), без четности информации, избыточности или отказоустойчивости . Поскольку RAID 0 не обеспечивает отказоустойчивости или избыточности, отказ одного диска приведет к отказу всего массива; в результате чередования данных по всем дискам сбой приведет к полной потере данных. Эта конфигурация обычно реализуется с заданной скоростью. [2] [3] RAID 0 обычно используется для повышения производительности, хотя его также можно использовать как способ создания большого логического тома из двух или более физических дисков.[4]

Настройка RAID 0 может быть создана с дисками разного размера, но пространство для хранения, добавляемое к массиву каждым диском, ограничено размером самого маленького диска. Например, если диск на 120 ГБ чередуется с диском на 320 ГБ, размер массива будет 120 ГБ × 2 = 240 ГБ. Однако некоторые реализации RAID позволяют использовать оставшиеся 200 ГБ для других целей.

На схеме в этом разделе показано, как данные распределяются по полосам A x на двух дисках, с A1: A2 в качестве первой полосы, A3: A4 в качестве второй и т. Д. После определения размера полосы во время создания RAID 0, его необходимо поддерживать постоянно. Поскольку доступ к полосам осуществляется параллельно, массив RAID 0 с n дисками выглядит как один большой диск со скоростью передачи данных, в n раз превышающей скорость одного диска.

Производительность [ править ]

Массив RAID 0 из n дисков обеспечивает скорость чтения и записи данных, в n раз превышающую скорость отдельных дисков, но без избыточности данных. В результате RAID 0 в основном используется в приложениях, требующих высокой производительности и допускающих более низкую надежность, например, в научных вычислениях [5] или компьютерных играх . [6]

Некоторые тесты настольных приложений показывают, что производительность RAID 0 несколько выше, чем у одного диска. [7] [8] В другой статье были рассмотрены эти утверждения и сделан вывод, что «чередование не всегда увеличивает производительность (в определенных ситуациях оно фактически будет медленнее, чем установка без RAID), но в большинстве случаев это приведет к значительному повышению производительности. ". [9] [10] Синтетические тесты показывают разные уровни повышения производительности при использовании нескольких жестких или твердотельных накопителей в конфигурации RAID 0 по сравнению с производительностью одного диска. Однако некоторые синтетические тесты также показывают падение производительности для того же сравнения. [11] [12]

RAID 1 [ править ]

RAID 1 состоит из точной копии (или зеркала ) набора данных на двух или более дисках; Классическая зеркальная пара RAID 1 состоит из двух дисков. Эта конфигурация не предлагает четности, чередования или распределения дискового пространства на нескольких дисках, поскольку данные зеркалируются на всех дисках, принадлежащих массиву, а размер массива может быть не меньше размера самого маленького диска-члена. Этот макет полезен, когда производительность или надежность чтения более важны, чем производительность записи или результирующая емкость хранилища данных. [13] [14]

Массив будет продолжать работать, пока работает хотя бы один диск-член. [15]

Производительность [ править ]

Любой запрос на чтение может обслуживаться и обрабатываться любым диском в массиве; таким образом, в зависимости от характера нагрузки ввода-вывода, производительность произвольного чтения массива RAID 1 может равняться сумме производительности каждого члена [a], в то время как производительность записи остается на уровне одного диска. Однако, если в массиве RAID 1 используются диски с разной скоростью, общая производительность записи равна скорости самого медленного диска. [14] [15]

Синтетические тесты показывают различные уровни повышения производительности при использовании нескольких жестких дисков или твердотельных накопителей в конфигурации RAID 1 по сравнению с производительностью одного диска. Однако некоторые синтетические тесты также показывают падение производительности для того же сравнения. [11] [12]

RAID 2 [ править ]

RAID 2 , который редко используется на практике, разделяет данные на битовом (а не на блочном) уровне и использует код Хэмминга для исправления ошибок . Диски синхронизируются контроллером для вращения с одинаковой угловой ориентацией (они достигают индекса одновременно [16] ), поэтому обычно он не может обслуживать несколько запросов одновременно. [17] [18] Однако, в зависимости от высокоскоростного кода Хэмминга , многие шпиндели будут работать параллельно для одновременной передачи данных, так что возможны «очень высокие скорости передачи данных» [19], как, например, в DataVault, где 32 бита данных были переданы одновременно.

Поскольку все жесткие диски реализуют внутреннюю коррекцию ошибок, сложность внешнего кода Хэмминга дает небольшое преимущество перед контролем четности, поэтому RAID 2 реализовывался редко; это единственный исходный уровень RAID, который в настоящее время не используется. [17] [18]

RAID 3 [ править ]

RAID 3 , который редко используется на практике, состоит из чередования на уровне байтов с выделенным диском четности . Одной из характеристик RAID 3 является то, что он, как правило, не может обслуживать несколько запросов одновременно, что происходит из-за того, что любой отдельный блок данных по определению будет распределен по всем членам набора и будет находиться в одном и том же физическом месте на каждом диске. Следовательно, любая операция ввода-вывода требует активности на каждом диске и обычно требует синхронизированных шпинделей.

Это делает его подходящим для приложений, требующих максимальной скорости передачи при длительном последовательном чтении и записи, например, для редактирования несжатого видео . Приложения, выполняющие небольшие операции чтения и записи из случайных мест на диске, получат худшую производительность из этого уровня. [18]

Требование , чтобы все диски вращаются синхронно (в ногу ) добавили конструктивные соображения , которые не представили существенных преимуществ по сравнению с другими уровнями RAID. И RAID 3, и RAID 4 были быстро заменены на RAID 5. [20] RAID 3 обычно реализовывался аппаратно, и проблемы с производительностью решались за счет использования больших дисковых кешей. [18]

RAID 4 [ править ]

RAID 4 состоит из блока -LEVEL чередования с выделенным паритетным диском. Благодаря своей структуре RAID 4 обеспечивает хорошую производительность случайного чтения, в то время как производительность случайной записи низка из-за необходимости записи всех данных четности на один диск. [21]

На диаграмме 1 запрос чтения для блока A1 будет обслуживаться диском 0. Одновременный запрос чтения для блока B1 должен ждать, но запрос чтения для B2 может одновременно обслуживаться диском 1.

RAID 5 [ править ]

RAID 5 состоит из чередования на уровне блоков с распределенной четностью. В отличие от RAID 4, информация о четности распределяется между дисками. Для работы требуется наличие всех приводов, кроме одного. При выходе из строя одного диска последующие чтения могут быть рассчитаны на основе распределенной четности, так что данные не будут потеряны. [5] RAID 5 требует как минимум трех дисков. [22]

В массиве дисков RAID 5 существует множество схем размещения данных и четности в зависимости от последовательности записи на диски [23] , а именно:

- последовательность блоков данных, записываемых слева направо или справа налево на дисковом массиве, с дисков от 0 до N, и

- расположение блока четности в начале или конце полосы, и

- расположение первого блока страйпа относительно четности предыдущего страйпа.

На рисунке справа показаны 1) блоки данных, записанные слева направо, 2) блок четности в конце полосы и 3) первый блок следующей полосы, находящийся не на том же диске, что и блок четности предыдущей полосы. Его можно обозначить как левую асинхронную схему RAID 5 [23], и это единственная схема, указанная в последнем издании Raid Book [24], опубликованном несуществующим Raid Advisory Board. [25] В синхронной компоновке первый блок данных следующей полосы записывается на том же диске, что и блок четности предыдущей полосы.

По сравнению с RAID 4 распределенная четность RAID 5 выравнивает нагрузку на выделенный диск четности среди всех участников RAID. Кроме того, производительность записи увеличивается, поскольку все члены RAID участвуют в обслуживании запросов на запись. Хотя это будет не так эффективно, как установка с чередованием (RAID 0), поскольку четность все еще должна быть записана, это больше не является узким местом. [26]

Поскольку вычисление четности выполняется на всей полосе, небольшие изменения в массиве вызывают усиление записи [ необходима цитата ] : в худшем случае, когда должен быть записан единственный логический сектор, необходимо прочитать исходный сектор и соответствующий сектор четности , исходные данные удаляются из четности, новые данные вычисляются в четности, и записываются как новый сектор данных, так и новый сектор четности.

RAID 6 [ править ]

RAID 6 расширяет RAID 5, добавляя еще один блок четности ; Таким образом, он использует блок -level чередования с двумя блоками четности , распределенных по всем дискам. [27]

Как и в RAID 5, существует множество компоновок дисковых массивов RAID 6 в зависимости от направления записи блоков данных, расположения блоков четности по отношению к блокам данных и от того, записан ли первый блок данных последующего страйпа. на тот же диск, что и последний блок четности предыдущего страйпа. Рисунок справа - лишь один из многих таких макетов.

По данным ассоциации Storage Networking Industry Association (SNIA), определение RAID 6 таково: «Любая форма RAID, которая может продолжать выполнять запросы чтения и записи ко всем виртуальным дискам RAID-массива при наличии любых двух одновременных сбоев дисков. Несколько методов, включая вычисления данных двойной проверки (четность и Рида – Соломона ), данные ортогональной двойной проверки четности и диагональная четность, были использованы для реализации RAID уровня 6. " [28]

Производительность [ править ]

RAID 6 не снижает производительность операций чтения, но снижает производительность операций записи из-за накладных расходов, связанных с вычислениями четности. Производительность сильно различается в зависимости от того, как RAID 6 реализован в архитектуре хранилища производителя - в программном обеспечении, встроенном ПО или с помощью встроенного ПО и специализированных ASIC для интенсивных вычислений четности. RAID 6 может читать с той же скоростью, что и RAID 5, с тем же количеством физических дисков. [29]

Когда используется диагональная или ортогональная двойная четность, для операций записи необходимо второе вычисление четности. Это вдвое увеличивает накладные расходы ЦП для записи RAID-6 по сравнению с уровнями RAID с одинарной четностью. Когда используется код Рида-Соломона, вычисление второй четности не требуется. Преимущество Reed Solomon заключается в том, что вся информация избыточности может содержаться в пределах заданной полосы.

Упрощенный пример паритета [ править ]

Предположим, мы хотим распределить наши данные по кускам. Наша цель - определить два значения четности и , известные как синдромы , в результате создать систему физических дисков, устойчивую к потере любых двух из них. Чтобы сгенерировать более одного независимого синдрома, нам нужно будет выполнить наши вычисления четности для блоков данных размером . Типичный выбор на практике - это размер блока , то есть чередование данных по байтам. Мы будем обозначать представление блока данных по основанию 2 как , где каждое значение равно 0 или 1.

Если мы используем небольшое количество фрагментов , мы можем использовать простое вычисление четности, которое поможет мотивировать использование системы Рида – Соломона в общем случае. Для нашего первого значения четности мы вычисляем простую операцию XOR данных по полосам, как в случае с RAID 5. Это записывается

и восстановить потерянные данные , отменив битовый сдвиг. Мы также можем восстановиться после отказа двух дисков с данными, вычислив XOR для оставшихся данных и с ними. Если бы в предыдущем примере кусок также был потерян, мы бы вычислили

Эта система больше не будет работать с большим количеством дисков . Это потому, что, если мы несколько раз применяем оператор сдвига к отрезку длины , мы вернемся к тому месту, где начали. Если бы мы попытались применить описанный выше алгоритм к системе, содержащей диски с данными, правая часть второго уравнения была бы такой же, как и первая система уравнений. Это даст только половину того количества уравнений, которое необходимо для решения недостающих значений.

Общая система паритета [ править ]

Можно поддерживать гораздо большее количество дисков, более тщательно выбирая функцию четности. Проблема, с которой мы сталкиваемся, состоит в том, чтобы гарантировать, что система уравнений над конечным полем имеет единственное решение, поэтому мы обратимся к теории полиномиальных уравнений. Рассмотрим поле Галуа с . Это поле изоморфно полиномиальному полю для подходящего неприводимого полинома степени над . Мы представим элементы данных в виде полиномов в поле Галуа. Пусть соответствует полосам данных на жестких дисках, закодированных таким образом как элементы поля. Мы будем использовать для обозначения сложения в поле и конкатенации для обозначения умножения. Повторное использование намеренно: это связано с тем, что сложение в конечном поле представляет собой оператор XOR, поэтому вычисление суммы двух элементов эквивалентно вычислению XOR над коэффициентами полинома.

Генератор поля является элементом поля таким образом, что отличается для каждого неотрицательного . Это означает, что каждый элемент поля, кроме значения , может быть записан как степень . Конечное поле гарантированно имеет хотя бы один генератор. Выберите один такой генератор , а также определить и следующим образом :

Как и раньше, первая контрольная сумма - это просто XOR каждой полосы, хотя теперь она интерпретируется как полином. Эффект можно представить как действие тщательно подобранного сдвигового регистра с линейной обратной связью на блок данных. [30] В отличие от сдвига битов в упрощенном примере, который можно было применить только несколько раз до того, как кодирование начало повторяться, многократное применение оператора гарантирует создание уникальных обратимых функций, которые позволят фрагменту длиной до поддерживать до данных шт.

Если один блок данных потерян, ситуация аналогична предыдущей. В случае потери двух блоков данных мы можем вычислить формулы восстановления алгебраически. Предположим, что и являются потерянными значениями с , тогда, используя другие значения , мы находим константы и :

Мы можем решить второе уравнение и подставить его в первое, чтобы найти , а затем .

В отличие от P , вычисление Q требует значительных ресурсов ЦП, поскольку включает в себя полиномиальное умножение в . Это можно смягчить с помощью аппаратной реализации или использования FPGA .

Сравнение [ править ]

Этот раздел требует дополнительных ссылок для проверки . ( Январь 2015 г. ) ( Узнайте, как и когда удалить этот шаблон сообщения ) |

В следующей таблице представлен обзор некоторых рекомендаций для стандартных уровней RAID. В каждом случае:

- Эффективность пространства массива выражается в виде числа дисков n ; это выражение обозначает дробное значение от нуля до единицы, представляющее долю суммы емкостей накопителей, доступную для использования. Например, если три диска расположены в RAID 3, это дает эффективность использования пространства массива 1 - 1 / n = 1 - 1/3 = 2/3 ≈ 67% ; таким образом, если каждый диск в этом примере имеет емкость 250 ГБ, то общая емкость массива составляет 750 ГБ, но емкость, которую можно использовать для хранения данных, составляет всего 500 ГБ.

| Уровень | Описание | Минимальное количество дисков [b] | Эффективность использования пространства | Отказоустойчивость | Читать производительность | Производительность записи |

|---|---|---|---|---|---|---|

| как фактор одного диска | ||||||

| RAID 0 | Чередование на уровне блоков без четности или зеркалирования | 2 | 1 | Никто | п | п |

| RAID 1 | Зеркальное отображение без четности или чередования | 2 | 1/п | n - 1 отказ диска | n [a] [15] | 1 [c] [15] |

| RAID 2 | Чередование битов с кодом Хэмминга для исправления ошибок | 3 | 1 - 1/пжурнал 2 ( n + 1) | Сбой одного диска [d] | Зависит | Зависит |

| RAID 3 | Чередование байтов с выделенной четностью | 3 | 1 - 1/п | Сбой одного диска | п - 1 | n - 1 [e] |

| RAID 4 | Чередование на уровне блоков с выделенной четностью | 3 | 1 - 1/п | Сбой одного диска | п - 1 | n - 1 [e] [ необходима ссылка ] |

| RAID 5 | Чередование на уровне блоков с распределенной четностью | 3 | 1 - 1/п | Сбой одного диска | n [e] | один сектор: 1/4 полная полоса: n - 1 [e] [ необходима ссылка ] |

| RAID 6 | Чередование на уровне блоков с двойной распределенной четностью | 4 | 1 - 2/п | Сбой двух дисков | n [e] | один сектор: 1/6 полная полоса: n - 2 [e] [ необходима ссылка ] |

Системные последствия [ править ]

При измерении производительности ввода-вывода пяти файловых систем с пятью конфигурациями хранения - одним SSD, RAID 0, RAID 1, RAID 10 и RAID 5 было показано, что F2FS на RAID 0 и RAID 5 с восемью SSD превосходит EXT4 в 5 раз. и 50 раз соответственно. Измерения также показывают, что RAID-контроллер может быть значительным узким местом при построении RAID-системы с высокоскоростными твердотельными накопителями. [31]

Вложенный RAID [ править ]

Комбинации двух или более стандартных уровней RAID. Они также известны как RAID 0 + 1 или RAID 01, RAID 0 + 3 или RAID 03, RAID 1 + 0 или RAID 10, RAID 5 + 0 или RAID 50, RAID 6 + 0 или RAID 60 и RAID 10 + 0. или RAID 100.

Нестандартные варианты [ править ]

Помимо стандартных и вложенных уровней RAID, альтернативы включают нестандартные уровни RAID и архитектуры дисков без RAID . Архитектуры дисков без RAID обозначаются аналогичными терминами и сокращениями, в частности, JBOD («просто группа дисков»), SPAN / BIG и MAID («массивный массив бездействующих дисков»).

Заметки [ править ]

- ^ a b Теоретический максимум, на практике всего лишь производительность одного диска

- ^ Предполагает невырожденное минимальное количество дисков

- ^ Если в массиве RAID 1 используются диски с разной скоростью, общая производительность записи равна скорости самого медленного диска.

- ^ RAID 2 может восстанавливаться после сбоя одного диска или восстанавливать поврежденные данные или четность, если соответствующие данные и четность поврежденного бита в порядке.

- ^ a b c d e f Предполагается, что оборудование способно достаточно быстро выполнять соответствующие вычисления.

Ссылки [ править ]

- ^ "Общий формат данных диска рейда (DDF)" . SNIA.org . Промышленная ассоциация сетей хранения данных . Проверено 23 апреля 2013 .

- ^ «Восстановление данных RAID 0» . DataRecovery.net . Проверено 30 апреля 2015 .

- ^ «Понимание RAID» . CRU-Inc.com . Проверено 30 апреля 2015 .

- ^ «Как объединить несколько жестких дисков в один том для получения дешевого хранилища большой емкости» . LifeHacker.com . 2013-02-26 . Проверено 30 апреля 2015 .

- ^ a b Чен, Питер; Ли, Эдвард; Гибсон, Гарт; Кац, Рэнди; Паттерсон, Дэвид (1994). «RAID: высокопроизводительное и надежное вторичное хранилище». ACM Computing Surveys . 26 (2): 145–185. CiteSeerX 10.1.1.41.3889 . DOI : 10.1145 / 176979.176981 . S2CID 207178693 .

- ^ де Кутер, Себастьян (2015-04-13). «Обзор игровых хранилищ в 2015 году: SSD, HDD или RAID 0, что лучше?» . GamePlayInside.com . Проверено 22 сентября 2015 .

- ^ "Хищники Western Digital в RAID-0: два диска лучше, чем один?" . AnandTech.com . AnandTech . 1 июля 2004 . Проверено 24 ноября 2007 .

- ^ «Hitachi Deskstar 7K1000: два терабайта RAID Redux» . AnandTech.com . AnandTech . 23 апреля 2007 . Проверено 24 ноября 2007 .

- ^ "RAID 0: шумиха или благословение?" . Tweakers.net . Онлайн-сервисы Persgroep. 7 августа 2004 . Проверено 23 июля 2008 .

- ^ "Действительно ли RAID0 увеличивает производительность диска?" . HardwareSecrets.com . 1 ноября 2006 г.

- ^ a b Ларабель, Майкл (2014-10-22). «Тестирование жесткого диска Btrfs RAID в Ubuntu Linux 14.10» . Фороникс . Проверено 19 сентября 2015 .

- ^ a b Ларабель, Майкл (2014-10-29). «Btrfs на 4 × Intel SSD в RAID 0/1/5/6/10» . Фороникс . Проверено 19 сентября 2015 .

- ^ "FreeBSD Handbook: 19.3. RAID 1 - Mirroring" . FreeBSD.org . 2014-03-23 . Проверено 11 июня 2014 .

- ^ a b «Какой уровень RAID мне подходит ?: RAID 1 (зеркалирование)» . Adaptec.com . Adaptec . Проверено 2 января 2014 .

- ^ a b c d «Выбор наилучшего уровня RAID: массивы RAID 1 (Руководство по установке HBA-адаптера шины Sun StorageTek SAS RAID)» . Docs.Oracle.com . Корпорация Oracle . 2010-12-23 . Проверено 2 января 2014 .

- ^ "RAID 2" . Техопедия . Техопедия . Проверено 11 декабря 2019 .

- ^ a b Вадала, Дерек (2003). Управление RAID в Linux. Серия О'Рейли (иллюстрированная ред.). О'Рейли . п. 6. ISBN 9781565927308.

- ^ a b c d Маркус, Эван; Стерн, Хэл (2003). Чертежи для обеспечения высокой доступности (2, иллюстрированное изд.). Джон Вили и сыновья . п. 167. ISBN. 9780471430261.

- ^ RAIDbook, 4 - е издание, The RAID Advisory Board, июнь 1995, с.101

- ^ Мейерс, Майкл; Джерниган, Скотт (2003). Руководство Майка Мейерса A + по управлению и поиску и устранению неисправностей ПК (иллюстрированное издание). McGraw-Hill Professional . п. 321. ISBN. 9780072231465.

- ^ Натараджан, Рамеш (2011-11-21). «RAID 2, RAID 3, RAID 4 и RAID 6, объясненные с помощью диаграмм» . TheGeekStuff.com . Проверено 2 января 2015 .

- ^ "Часто задаваемые вопросы о восстановлении данных RAID 5" . VantageTech.com . Vantage Technologies . Проверено 16 июля 2014 .

- ^ a b «Информация о RAID - Алгоритмы Linux RAID-5» . Эшфордская компьютерная консалтинговая служба . Проверено 16 февраля 2021 года .

- ^ Massigilia, Пол (февраль 1997). Книга RAID, 6-е издание . Консультативный совет по RAID. С. 101–129.

- ^ «Добро пожаловать в Консультативный совет по RAID» . Консультативный совет по RAID. 6 апреля 2001 . Проверено 16 февраля 2021 года . Последняя действующая заархивированная веб-страница на Wayback Machine}}

- ^ Корен, Израиль. «Основные организации RAID» . ECS.UMass.edu . Массачусетский университет . Проверено 4 ноября 2014 .

- ^ «Руководство по установке HBA-адаптера шины Sun StorageTek SAS RAID, приложение F: Выбор наилучшего уровня RAID: массивы RAID 6» . Docs.Oracle.com . 2010-12-23 . Проверено 27 августа 2015 .

- ^ «Словарь R» . SNIA.org . Промышленная ассоциация сетей хранения данных . Проверено 24 ноября 2007 .

- ↑ Вера, Рикард Э. (13 мая 2009 г.). «Сравнение типов программного RAID» . Cite journal requires

|journal=(help) - ^ Anvin, H. Peter (21 мая 2009). «Математика RAID-6» (PDF) . Kernel.org . Организация ядра Linux . Проверено 4 ноября 2009 года .

- ^ Парк, Chanhyun; Ли, Сонджин; Вон, Youjip (2014). Анализ эмпирической производительности RAID на основе SSD . Информационные науки и системы . 2014 . С. 395–405. DOI : 10.1007 / 978-3-319-09465-6_41 . ISBN 978-3-319-09464-9.

Дальнейшее чтение [ править ]

- «Изучение RAID» . Support.Dell.com . Dell . 2009. Архивировано из оригинала на 2009-02-20 . Проверено 15 апреля 2016 .

- Избыточные массивы недорогих дисков (RAID) , глава 38 из книги « Операционные системы: три простых элемента» Ремзи Х. Арпачи-Дюссо и Андреа К. Арпачи-Дюссо

Внешние ссылки [ править ]

- Сводка IBM по уровням RAID

- Инструмент для объяснения и проверки четности RAID 5

- Калькулятор RAID для стандартных уровней RAID и других инструментов RAID

- Руководство пользователя Sun StorEdge 3000 Family Configuration Service 2.5: основы RAID

![{\ Displaystyle F_ {2} [х] / (п (х))}](https://wikimedia.org/api/rest_v1/media/math/render/svg/5a94539f2b3a0114d3e0d1f244a9a4a657b0995d)