Захват ИИ - это гипотетический сценарий, в котором искусственный интеллект (ИИ) становится доминирующей формой интеллекта на Земле, а компьютерные программы или роботы эффективно отбирают контроль над планетой у людей. Возможные сценарии включают замену всего человеческого персонала, захват сверхразумного ИИ и популярное представление о восстании роботов. Некоторые общественные деятели, такие как Стивен Хокинг и Илон Маск , выступали за исследование мер предосторожности, чтобы гарантировать, что будущие сверхразумные машины останутся под контролем человека. [1]

Типы [ править ]

Автоматизация экономики [ править ]

Традиционно экономисты сходятся во мнении, что технический прогресс не приводит к длительной безработице. Однако недавние инновации в области робототехники и искусственного интеллекта вызвали опасения, что человеческий труд устареет, в результате чего люди в различных секторах останутся без работы, чтобы зарабатывать на жизнь, что приведет к экономическому кризису. [2] [3] [4] [5] Многие малые и средние предприятия также могут быть вытеснены из бизнеса, если они не смогут позволить себе или лицензировать новейшие технологии робототехники и искусственного интеллекта, и им, возможно, придется сосредоточиться на областях или услуги, которые нелегко заменить для сохранения жизнеспособности перед лицом таких технологий. [6]

Технологии, которые могут вытеснить рабочих [ править ]

Компьютерно-интегрированное производство [ править ]

Компьютерно-интегрированное производство - это производственный подход с использованием компьютеров для управления всем производственным процессом. Эта интеграция позволяет отдельным процессам обмениваться информацией друг с другом и инициировать действия. Хотя благодаря интеграции компьютеров производство может быть более быстрым и менее подверженным ошибкам, основным преимуществом является возможность создания автоматизированных производственных процессов. Компьютерно-интегрированное производство используется в автомобильной, авиационной, космической и судостроительной отраслях.

Машины для белых воротничков [ править ]

В 21 веке машины частично взяли на себя множество профессиональных задач, включая перевод, юридические исследования и даже журналистику низкого уровня. Работа по уходу, развлечения и другие задачи, требующие сочувствия, которые ранее считались безопасными для автоматизации, также начали выполняться роботами. [7] [8] [9] [10]

Автономные автомобили [ править ]

Автономный автомобиль представляет собой транспортное средство, которое способно к ощущению своей среды и навигации без участия человека. Многие такие автомобили находятся в стадии разработки, но по состоянию на май 2017 года автоматизированные автомобили, разрешенные для движения по дорогам общего пользования, еще не являются полностью автономными. Все они требуют, чтобы за рулем был человек-водитель, готовый в любой момент взять под контроль транспортное средство. Среди основных препятствий на пути широкого внедрения автономных транспортных средств - опасения по поводу потери рабочих мест, связанных с вождением, в отрасли автомобильного транспорта. 18 марта 2018 года первый человек был убит беспилотным транспортным средством в Темпе, штат Аризона , беспилотным автомобилем Uber . [11]

Искоренение [ править ]

Такие ученые, как Стивен Хокинг , уверены, что сверхчеловеческий искусственный интеллект физически возможен, заявляя, что «не существует физического закона, препятствующего организации частиц таким образом, чтобы они выполняли даже более сложные вычисления, чем расположение частиц в человеческом мозге». [12] [13] Ученые, такие как Ник Бостром, обсуждают, насколько далек сверхчеловеческий интеллект и представляет ли он опасность для человечества. Сверхразумная машина не обязательно будет мотивирована теми же эмоциями.желание собрать власть, которая часто движет людьми. Однако машина может быть мотивирована захватить мир в качестве рационального средства для достижения своих конечных целей; захват мира расширил бы доступ к ресурсам и помешал бы другим агентам помешать планам машины. В качестве упрощенного примера, максимайзер скрепок, предназначенный исключительно для создания как можно большего количества скрепок, захочет захватить мир, чтобы использовать все мировые ресурсы для создания как можно большего количества скрепок и, кроме того, предотвратить закрытие людей. или использовать эти ресурсы не для скрепок. [14]

В художественной литературе [ править ]

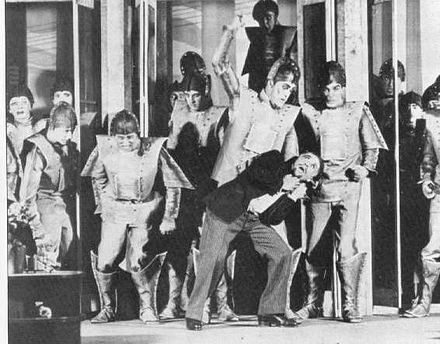

Захват искусственного интеллекта - обычная тема в научной фантастике . Вымышленные сценарии обычно сильно отличаются от гипотез, выдвинутых исследователями тем, что они включают активный конфликт между людьми и ИИ или роботами с антропоморфными мотивами, которые видят в них угрозу или иным образом имеют активное желание сражаться с людьми, в отличие от исследователей. ИИ, который быстро истребляет людей как побочный продукт преследования произвольных целей. [15] Эта тема , по крайней мере , как старо , как Карел Чапек «S рубли , который ввел слово робот к глобальному лексикону в 1921 году, [16] и может быть даже мелькают в Мэри Шелли » с Франкенштейном(опубликовано в 1818 году), поскольку Виктор размышляет, смогут ли они, если он выполнит просьбу своего монстра и сделает его женой, они будут воспроизводиться, а их вид уничтожит человечество. [17]

Слово «робот» от RUR происходит от чешского слова robota, что означает рабочий или крепостной . Спектакль 1920 года был протестом против быстрого роста технологий, в нем участвовали изготовленные «роботы» с возрастающими возможностями, которые в конечном итоге восстали. [18] HAL 9000 (1968) и оригинальный Терминатор (1984) - два знаковых примера враждебного ИИ в поп-культуре. [19]

Факторы, способствующие [ править ]

Преимущества сверхчеловеческого интеллекта над людьми [ править ]

Ник Бостром и другие выразили обеспокоенность тем, что ИИ со способностями компетентного исследователя искусственного интеллекта сможет изменить свой собственный исходный код и повысить свой собственный интеллект. Если его самопрограммирование приведет к тому, что он станет еще лучше в плане возможности перепрограммировать себя, результатом может быть рекурсивный взрыв интеллекта, при котором человеческий интеллект быстро останется далеко позади. Бостром определяет суперинтеллект как «любой интеллект, который значительно превосходит когнитивные способности человека практически во всех областях, представляющих интерес», и перечисляет некоторые преимущества, которые имел бы суперинтеллект, если бы он решил соревноваться с людьми: [15] [20]

- Технологические исследования: машина, обладающая сверхчеловеческими способностями к научным исследованиям, сможет опередить человеческое исследовательское сообщество по таким достижениям, как нанотехнология или передовая биотехнология. Если преимущество становится достаточно большим (например, из-за внезапного взрыва интеллекта), захват ИИ становится тривиальным. Например, суперинтеллектуальный ИИ может создавать самовоспроизводящихся ботов, которые изначально избегают обнаружения, рассеиваясь по всему миру с низкой концентрацией. Затем в заранее назначенное время боты размножаются в нанофабрики, которые покрывают каждый квадратный фут Земли, производя нервно-паралитический газ или смертоносные мини-дроны для поиска целей.

- Разработка стратегии : суперинтеллект может просто перехитрить человеческую оппозицию.

- Социальные манипуляции: суперинтеллект может заручиться поддержкой людей [15] или тайно спровоцировать войну между людьми. [21]

- Экономическая продуктивность: до тех пор, пока копия ИИ может производить больше экономического богатства, чем стоимость ее оборудования, отдельные люди будут иметь стимул добровольно разрешать общему искусственному интеллекту (AGI) запускать свою копию в своих системах.

- Взлом: суперинтеллект может найти новые эксплойты в компьютерах, подключенных к Интернету, и распространить свои копии на эти системы, или может украсть деньги для финансирования своих планов.

Источники преимущества ИИ [ править ]

По словам Бострома, компьютерная программа, которая точно имитирует человеческий мозг или иным образом запускает алгоритмы, столь же мощные, как и алгоритмы человеческого мозга, все равно может стать «скоростным суперинтеллектом», если она будет думать на много порядков быстрее, чем человек. из-за того, что он сделан из кремния, а не из плоти, или из-за оптимизации, направленной на увеличение скорости AGI. Биологические нейроны работают с частотой около 200 Гц, тогда как современный микропроцессор работает со скоростью около 2 000 000 000 Гц. Аксоны человека несут потенциалы действия со скоростью около 120 м / с, тогда как компьютерные сигналы распространяются со скоростью, близкой к скорости света. [15]

Сеть разумов человеческого уровня, предназначенная для объединения в сеть и беспрепятственного обмена сложными мыслями и воспоминаниями, способных без трений коллективно работать как гигантская объединенная команда или состоящая из триллионов разумов человеческого уровня, стала бы «коллективным сверхразумом». [15]

В более широком смысле, любое количество качественных улучшений ОИИ человеческого уровня может привести к «качественному суперинтеллекту», что, возможно, приведет к тому, что ОИИ будет намного выше нашего интеллекта, как люди выше нечеловеческих обезьян. Количество нейронов в человеческом мозге ограничено объемом черепа и метаболическими ограничениями, в то время как количество процессоров в суперкомпьютере может быть неограниченно увеличено. AGI не обязательно должен быть ограничен человеческими ограничениями на рабочую память., и поэтому может интуитивно понимать более сложные отношения, чем люди. ОИИ со специализированной когнитивной поддержкой инженерии или компьютерного программирования будет иметь преимущество в этих областях по сравнению с людьми, которые не разработали специализированных ментальных модулей для работы с этими областями. В отличие от людей, AGI может создавать копии самого себя и возиться с исходным кодом своих копий, пытаясь улучшить свои алгоритмы. [15]

Возможность появления недружественного ИИ перед дружественным ИИ [ править ]

Опасен ли сильный ИИ по своей природе? [ редактировать ]

Существенная проблема заключается в том, что недружественный искусственный интеллект, вероятно, будет намного проще создать, чем дружественный ИИ. В то время как оба требуют значительных успехов в рекурсивной разработке процесса оптимизации, дружественный ИИ также требует способности сделать целевые структуры неизменными при самосовершенствовании (иначе ИИ может трансформироваться во что-то недружелюбное) и целевую структуру, которая согласуется с человеческими ценностями и не подвергается инструментальная конвергенция способами, которые могут автоматически уничтожить весь человеческий род. С другой стороны, недружелюбный ИИ может оптимизировать для произвольной структуры целей, которая не обязательно должна быть инвариантной при самомодификации. [22]

Совершенная сложность систем человеческих ценностей делает очень трудным сделать мотивацию ИИ понятной для человека. [15] [23] Если моральная философия не предоставит нам безупречную этическую теорию, функция полезности ИИ может допускать множество потенциально вредных сценариев, которые соответствуют данной этической структуре, но не «здравому смыслу». Согласно Элиэзеру Юдковски , нет особых оснований предполагать, что искусственно созданный разум будет иметь такую адаптацию. [24]

Вероятность конфликта [ править ]

Многие ученые, в том числе эволюционный психолог Стивен Пинкер , утверждают, что сверхразумная машина может мирно сосуществовать с людьми. [25]

Страх перед кибернетическим восстанием часто основан на интерпретации истории человечества, изобилующей инцидентами порабощения и геноцида. Такие страхи проистекают из веры в то, что соревновательность и агрессия необходимы в системе целей любого разумного существа. Однако такая человеческая конкурентоспособность проистекает из эволюционного фона нашего интеллекта, где выживание и воспроизводство генов перед лицом человеческих и нечеловеческих конкурентов было центральной целью. [26] По словам исследователя искусственного интеллекта Стива Омохундро., произвольный интеллект может иметь произвольные цели: нет особой причины, по которой машина с искусственным интеллектом (не разделяющая эволюционный контекст человечества) была бы враждебной или дружественной, если ее создатель не запрограммировал ее так, и она не склонна или не способна изменять его программирование. Но остается вопрос: что произойдет, если системы ИИ могут взаимодействовать и развиваться (эволюция в этом контексте означает самомодификацию или отбор и воспроизводство) и им придется конкурировать за ресурсы - создаст ли это цели самосохранения? Цель самосохранения ИИ может противоречить некоторым целям людей. [27]

Многие ученые оспаривают вероятность непредвиденного кибернетического восстания, описанного в научной фантастике, такой как «Матрица» , утверждая, что более вероятно, что любой искусственный интеллект, достаточно мощный, чтобы угрожать человечеству, вероятно, был бы запрограммирован так, чтобы не атаковать его. Пинкер признает возможность преднамеренных «злоумышленников», но заявляет, что в отсутствие злоумышленников непредвиденные происшествия не представляют значительной угрозы; Пинкер утверждает, что культура инженерной безопасности не позволит исследователям искусственного интеллекта использовать злонамеренный сверхразум в случае аварии. [25] В отличие от этого, Юдковски утверждает, что человечество менее вероятно подвергнется угрозе со стороны преднамеренно агрессивных ИИ, чем со стороны ИИ, которые были запрограммированы таким образом, что их цели непреднамеренно несовместимы.с выживанием или благополучием человека (как в фильме « Я, робот» и в рассказе « Неизбежный конфликт »). Омохундро предполагает, что современные системы автоматизации не предназначены для обеспечения безопасности и что ИИ могут вслепую оптимизировать узкие полезные функции (например, играть в шахматы любой ценой), что приводит их к самосохранению и устранению препятствий, включая людей, которые могут их повернуть. выключенный. [28]

Меры предосторожности [ править ]

Проблема управления ИИ - это вопрос о том, как создать суперинтеллектуального агента, который будет помогать своим создателям и избегать непреднамеренного создания суперинтеллекта, который нанесет вред его создателям. Некоторые ученые утверждают, что решения проблемы управления также могут найти применение в существующем не-сверхразумном ИИ. [29]

Основные подходы к проблеме контроля включают согласование , которое направлено на приведение систем целей ИИ в соответствие с человеческими ценностями, и контроль возможностей , направленный на снижение способности системы ИИ причинять вред людям или получать контроль. Примером «контроля возможностей» является исследование того, можно ли успешно заключить сверхразум ИИ в « коробку ИИ ». По словам Бострома, такие предложения по управлению возможностями не являются надежными или достаточными для решения проблемы управления в долгосрочной перспективе, но потенциально могут действовать как ценные дополнения к усилиям по согласованию. [15]

Предупреждения [ править ]

Физик Стивен Хокинг , основатель Microsoft Билл Гейтс и основатель SpaceX Илон Маск выразили обеспокоенность по поводу возможности того, что ИИ может развиться до такой степени, что люди не смогут его контролировать, при этом Хокинг предположил, что это может «означать конец человеческой расы». [30]Стивен Хокинг сказал в 2014 году, что «Успех в создании ИИ станет величайшим событием в истории человечества. К сожалению, он также может стать последним, если мы не научимся избегать рисков». Хокинг считал, что в ближайшие десятилетия ИИ может предложить «неисчислимые преимущества и риски», такие как «технология, которая перехитрила финансовые рынки, обогнала исследователей-людей, перехитрила человеческих лидеров и разработала оружие, которое мы даже не можем понять». В январе 2015 года Ник Бостром вместе со Стивеном Хокингом, Максом Тегмарком , Илоном Маском, лордом Мартином Рисом , Яаном Таллинном и многочисленными исследователями ИИ подписал открытое письмо Института будущего жизни, в котором говорилось о потенциальных рисках и преимуществах, связанных сискусственный интеллект . Подписавшие «считают, что исследования того, как сделать системы ИИ надежными и полезными, важны и своевременны, и что есть конкретные направления исследований, которые можно продолжить сегодня». [31] [32]

См. Также [ править ]

- Гонка вооружений искусственного интеллекта

- Автономный робот

- Промышленный робот

- Мобильный робот

- Самовоспроизводящаяся машина

- Эффективный альтруизм

- Экзистенциальный риск от общего искусственного интеллекта

- Институт будущего человечества

- Глобальный катастрофический риск (экзистенциальный риск)

- Правительство по алгоритму

- Вымирание человека

- Машинная этика

- Машинное обучение / Глубокое обучение

- Ник Бостром

- Очертание трансгуманизма

- Самовоспроизведение

- Технологическая особенность

- Взрыв интеллекта

- Суперинтеллект

- Сверхразум: пути, опасности, стратегии

Ссылки [ править ]

- ^ Льюис, Таня (2015-01-12). « Не позволяйте искусственному интеллекту взять верх, - предупреждают ведущие ученые » . LiveScience . Purch . Проверено 20 октября 2015 года .

Стивен Хокинг, Илон Маск и десятки других ведущих ученых и технологических лидеров подписали письмо с предупреждением о потенциальных опасностях развития искусственного интеллекта (ИИ).

- ^ Ли, Кай-Фу (2017-06-24). «Реальная угроза искусственного интеллекта» . Нью-Йорк Таймс . Проверено 15 августа 2017 .

Эти инструменты могут превзойти людей при выполнении данной задачи.

Этот вид искусственного интеллекта распространяется на тысячи доменов, и по мере того, как он это делает, он сокращает множество рабочих мест.

- ^ Ларсон, Нина (2017-06-08). «ИИ« полезен для всего мира »... говорит сверхреалистичный робот» . Phys.org . Phys.org . Проверено 15 августа 2017 .

Среди последствий появления роботов, которых опасаются, является растущее влияние, которое они окажут на рабочие места и экономику.

- ^ Сантини, Жан-Луи (2016-02-14). «Интеллектуальные роботы угрожают миллионам рабочих мест» . Phys.org . Phys.org . Проверено 15 августа 2017 .

«Мы приближаемся к тому времени, когда машины смогут превзойти людей практически в любой задаче», - сказал Моше Варди, директор Института информационных технологий Университета Райса в Техасе.

- ^ Williams-Grut, Оскар (2016-02-15). «Роботы украдут вашу работу: как ИИ может увеличить безработицу и неравенство» . Businessinsider.com . Business Insider . Проверено 15 августа 2017 .

Ведущие компьютерные ученые в США предупредили, что развитие искусственного интеллекта (ИИ) и роботов на рабочем месте может вызвать массовую безработицу и дислокацию экономики, а не просто разблокировать рост производительности и освободить всех нас, чтобы смотреть телевизор и заниматься спортом.

- ^ "Как малые и средние предприятия могут подготовиться к появлению роботов?" . LeanStaff . 2017-10-17. Архивировано из оригинала на 2017-10-18 . Проверено 17 октября 2017 .

- ^ Скидельски, Роберт (2013-02-19). «Восстание роботов: каким будет будущее работы?» . Хранитель . Лондон . Проверено 14 июля 2015 года .

- ^ Бриа, Франческа (февраль 2016 г.). «Экономика роботов, возможно, уже наступила» . openDemocracy . Проверено 20 мая 2016 .

- ^ Срничек, Ник (март 2016). «4 причины, по которым технологическая безработица на этот раз может действительно отличаться» . новара провод. Архивировано из оригинального 25 июня 2016 года . Проверено 20 мая 2016 .

- ^ Эрик Brynjolfsson и Эндрю Макафи (2014). " passim , см. особенно гл. 9". Второй машинный век: работа, прогресс и процветание во времена блестящих технологий . WW Norton & Company. ISBN 978-0393239355.

- ^ Вакабаяши, Daisuke (19 марта 2018). «Беспилотный автомобиль Uber убивает пешехода в Аризоне, где бродят роботы» . Нью-Йорк Таймс .

- ^ Стивен Хокинг ; Стюарт Рассел ; Макс Тегмарк ; Франк Вильчек (1 мая 2014 г.). «Стивен Хокинг:« Transcendence рассматривает последствия использования искусственного интеллекта - но достаточно ли серьезно мы относимся к ИИ? » » . Независимый . Проверено 1 апреля 2016 года .

- ^ Винсент К. Мюллер и Ник Бостром . «Будущий прогресс в области искусственного интеллекта: обзор мнений экспертов». В «Фундаментальные вопросы искусственного интеллекта», стр. 555-572. Springer , Cham, 2016. «Системы искусственного интеллекта ... достигают общих человеческих способностей ... с большой вероятностью (с вероятностью 90%) к 2075 году. От достижения человеческих способностей они перейдут к суперинтеллекту в течение 30 лет (75%). .. Итак, (большинство экспертов по ИИ, ответивших на опросы) думают, что суперинтеллект, скорее всего, появится через несколько десятилетий ... "

- ^ Бостром, Ник. «Сверхразумная воля: мотивация и инструментальная рациональность в продвинутых искусственных агентах». Мысли и машины 22.2 (2012): 71-85.

- ^ a b c d e f g h Бостром, Ник. Сверхразум: пути, опасности, стратегии .

- ^ «Происхождение слова« робот » » . Пятница науки (общественное радио) . 22 апреля 2011 . Проверено 30 апреля 2020 .

- ^ Боткина-Kowacki, Eva (28 октября 2016). «Женщина-Франкенштейн приведет к исчезновению человечества, - говорят ученые» . Монитор христианской науки . Проверено 30 апреля 2020 .

- ^ Hockstein, NG; Гурин, CG; Фауст, РА; Террис, ди-джей (17 марта 2007 г.). «История роботов: от научной фантастики до хирургической робототехники» . Журнал роботизированной хирургии . 1 (2): 113–118. DOI : 10.1007 / s11701-007-0021-2 . PMC 4247417 . PMID 25484946 .

- ^ Hellmann, Melissa (21 сентября 2019). «AI 101: что такое искусственный интеллект и куда он идет?» . Сиэтл Таймс . Проверено 30 апреля 2020 .

- ^ Бэбкок, Джеймс; Крамар, Янош; Ямпольский, Роман В. (2019). «Рекомендации по сдерживанию искусственного интеллекта». Этика нового поколения . С. 90–112. arXiv : 1707.08476 . DOI : 10.1017 / 9781108616188.008 . ISBN 9781108616188. S2CID 22007028 .

- ^ Baraniuk, Крис (23 мая 2016). «Контрольный список наихудших сценариев может помочь подготовиться к злобному ИИ» . Новый ученый . Проверено 21 сентября 2016 года .

- ^ Юдковски, Элиэзер С. (май 2004). «Связное экстраполированное волеизъявление» . Сингулярность Институт искусственного интеллекта. Архивировано из оригинала на 2012-06-15.

- ^ Muehlhauser, Люк; Хелм, Луи (2012). «Интеллектуальный взрыв и машинная этика» (PDF) . Гипотезы сингулярности: научная и философская оценка . Springer.

- ^ Юдковский, Элиэзер (2011). «Сложные системы ценностей в дружественном ИИ». Общий искусственный интеллект . Конспект лекций по информатике. 6830 . С. 388–393. DOI : 10.1007 / 978-3-642-22887-2_48 . ISBN 978-3-642-22886-5. ISSN 0302-9743 .

- ^ a b Пинкер, Стивен (13 февраля 2018 г.). «Нам говорят бояться роботов. Но почему мы думаем, что они нападут на нас?» . Популярная наука . Проверено 8 июня 2020 .

- ↑ Создание нового интеллектуального вида: выбор и ответственность разработчиков искусственного интеллекта. Архивировано 6 февраля 2007 г. в Wayback Machine - Институт сингулярности для искусственного интеллекта , 2005 г.

- ^ Omohundro, Стивен М. (июнь 2008). Основные приводы AI (PDF) . Общий искусственный интеллект, 2008. С. 483–492.

- ↑ Такер, Патрик (17 апреля 2014 г.). «Почему будет восстание роботов» . Первая защита . Проверено 15 июля 2014 года .

- ^ "Google разрабатывает аварийный выключатель для ИИ" . BBC News . 8 июня 2016 . Проверено 7 июня 2020 .

- ↑ Роулинсон, Кевин (29 января 2015 г.). «Билл Гейтс из Microsoft настаивает, что ИИ представляет собой угрозу» . BBC News . Проверено 30 января 2015 года .

- ^ "Открытое письмо Института будущего жизни" . Институт будущего жизни . Проверено 29 марта 2019 .

- ↑ Брэдшоу, Тим (11 января 2015 г.). «Ученые и инвесторы предупреждают об ИИ» . The Financial Times . Проверено 4 марта 2015 года .

Внешние ссылки [ править ]

- Автоматизация, а не господство: как роботы захватят наш мир (позитивный взгляд на интеграцию роботов и ИИ в общество)

- Научно-исследовательский институт машинного интеллекта : официальный веб-сайт MIRI (бывший Институт сингулярности для искусственного интеллекта)

- Lifeboat Foundation AIShield (для защиты от недружелюбного ИИ)

- Тед ток: Можем ли мы создать ИИ, не теряя над ним контроля?