Эта статья поднимает множество проблем. Пожалуйста, помогите улучшить его или обсудите эти проблемы на странице обсуждения . ( Узнайте, как и когда удалить эти сообщения-шаблоны ) ( Узнайте, как и когда удалить этот шаблон сообщения )

|

Выбор модели - это задача выбора статистической модели из набора моделей-кандидатов с учетом данных. В простейших случаях рассматривается уже существующий набор данных. Однако задача также может включать в себя такой план экспериментов , чтобы собранные данные хорошо подходили для задачи выбора модели. Учитывая возможные модели с аналогичной предсказательной или объяснительной способностью, простейшая модель, скорее всего, будет лучшим выбором ( бритва Оккама ).

Кониси и Китагава (2008 , стр. 75) заявляют: «Большинство проблем статистического вывода можно рассматривать как проблемы, связанные со статистическим моделированием». В связи с этим Кокс (2006 , стр. 197) сказал: «Как [] перевод предметной проблемы в статистическую модель часто является наиболее важной частью анализа».

Выбор модели может также относиться к проблеме выбора нескольких репрезентативных моделей из большого набора вычислительных моделей с целью принятия решений или оптимизации в условиях неопределенности. [1]

Введение [ править ]

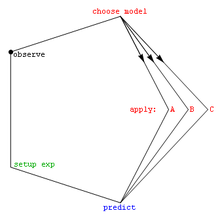

В самых основных формах выбор модели - одна из фундаментальных задач научного исследования . Определение принципа, объясняющего серию наблюдений, часто напрямую связано с математической моделью, предсказывающей эти наблюдения. Например, когда Галилео выполнил свои наклонную плоскость эксперименты, он показал , что движение шариков установлена парабола , предсказанную его модель [ править ] .

Из бесчисленного количества возможных механизмов и процессов, которые могли бы произвести данные, как можно даже начать выбирать лучшую модель? Обычно применяемый математический подход определяет набор моделей-кандидатов; этот набор должен быть выбран исследователем. Часто используются простые модели, такие как полиномы , по крайней мере, на начальном этапе [ необходима цитата ] . Бернхэм и Андерсон (2002) на протяжении всей своей книги подчеркивают важность выбора моделей, основанных на надежных научных принципах, таких как понимание феноменологических процессов или механизмов (например, химических реакций), лежащих в основе данных.

После выбора набора моделей-кандидатов статистический анализ позволяет нам выбрать лучшую из этих моделей. То, что подразумевается под лучшим , спорно. Хорошая методика выбора модели уравновешивает качество подгонки и простоту [ цитата ] . Более сложные модели смогут лучше адаптировать свою форму для соответствия данным (например, полином пятого порядка может точно соответствовать шести точкам), но дополнительные параметры могут не представлять ничего полезного. (Возможно, эти шесть точек на самом деле просто случайным образом распределены по прямой.) Качество соответствия обычно определяется с использованием подхода отношения правдоподобия или его приближения, что приводит к критерию хи-квадрат.. Сложность обычно измеряется путем подсчета количества параметров в модели.

Методы выбора модели можно рассматривать как оценки некоторой физической величины, например, вероятности того, что модель дает данные. Смещения и дисперсии являются важными показателями качества этой оценки; Эффективность также часто рассматривается.

Стандартный пример выбора модели - это подгонка кривой , где, учитывая набор точек и другие базовые знания (например, точки являются результатом выборок iid ), мы должны выбрать кривую, которая описывает функцию, которая сгенерировала точки.

Два направления выбора модели [ править ]

Вывод и обучение на основе данных преследуют две основные цели. Один - для научного открытия, понимания лежащего в основе механизма генерации данных и интерпретации природы данных. Другая цель обучения на основе данных - прогнозирование будущих или невидимых наблюдений. Во второй задаче специалист по анализу данных не обязательно заботится о точном вероятностном описании данных. Конечно, могут быть интересны и оба направления.

В соответствии с двумя разными целями, выбор модели также может иметь два направления: выбор модели для вывода и выбор модели для прогнозирования. [2] Первое направление - определить лучшую модель для данных, которая предпочтительно обеспечит надежную характеристику источников неопределенности для научной интерпретации. Для этой цели очень важно, чтобы выбранная модель не была слишком чувствительна к размеру выборки. Соответственно, подходящим понятием для оценки выбора модели является последовательность выбора, означающая, что наиболее надежный кандидат будет последовательно выбираться при достаточно большом количестве выборок данных.

Второе направление - выбрать модель в качестве механизма, обеспечивающего отличные прогностические характеристики. Для последнего, однако, выбранная модель может просто стать счастливым победителем среди нескольких близких конкурентов, но прогнозные характеристики могут быть наилучшими из возможных. Если это так, выбор модели подходит для второй цели (прогноз), но использование выбранной модели для понимания и интерпретации может быть крайне ненадежным и вводящим в заблуждение. [2]

Методы, помогающие выбрать набор моделей-кандидатов [ править ]

- Преобразование данных (статистика)

- Исследовательский анализ данных

- Спецификация модели

- Научный метод

Критерии [ править ]

Ниже приведен список критериев выбора модели. Наиболее часто используемые критерии - это (i) информационный критерий Акаике и (ii) байесовский фактор и / или байесовский информационный критерий (который в некоторой степени приближается к байесовскому фактору).

- Информационный критерий Акаике (AIC), мера соответствия оценочной статистической модели.

- Байесовский фактор

- Байесовский информационный критерий (BIC), также известный как информационный критерий Шварца, статистический критерий для выбора модели

- Мостовой критерий (BC), статистический критерий, который может обеспечить лучшую производительность AIC и BIC, несмотря на соответствие спецификации модели. [3]

- Перекрестная проверка

- Информационный критерий отклонения (DIC), еще один критерий выбора байесовской модели

- Коэффициент ложного обнаружения

- Критерий сфокусированной информации (FIC), критерий выбора, сортирующий статистические модели по их эффективности для заданного параметра фокусировки.

- Информационный критерий Ханнана – Куинна , альтернатива критериям Акаике и Байесу.

- Информационный критерий Кашьяпа (KIC) - мощная альтернатива AIC и BIC, поскольку KIC использует информационную матрицу Фишера.

- Тест отношения правдоподобия

- Mallows's C p

- Минимальная длина описания

- Минимальная длина сообщения (MML)

- Статистика PRESS , также известная как критерий PRESS

- Минимизация структурных рисков

- Пошаговая регрессия

- Информационный критерий Ватанабэ – Акаике (WAIC), также называемый широко применимым информационным критерием.

- Расширенный байесовский информационный критерий (EBIC) - это расширение обычного байесовского информационного критерия (BIC) для моделей с пространствами с высокими параметрами.

- Расширенный информационный критерий Фишера (EFIC) - это критерий выбора модели для моделей линейной регрессии.

Среди этих критериев перекрестная проверка обычно является наиболее точной и наиболее затратной с точки зрения вычислений для задач обучения с учителем.

Бернхэм и Андерсон (2002 , §6.3) говорят следующее (с добавленными вики-ссылками).

Существует множество методов выбора модели. Однако с точки зрения статистической производительности метода и предполагаемого контекста его использования существует только два различных класса методов: они были отмечены как эффективные и согласованные . .... Согласно частотной парадигме для выбора модели обычно используются три основных подхода: (I) оптимизация некоторых критериев выбора, (II) проверка гипотез и (III) специальные методы.

См. Также [ править ]

- Все модели неправильные

- Анализ конкурирующих гипотез

- Автоматизированное машинное обучение (AutoML)

- Дилемма смещения и дисперсии

- Выбор функции

- Парадокс Фридмана

- Поиск по сетке

- Анализ идентифицируемости

- Логлинейный анализ

- Идентификация модели

- бритва Оккама

- Оптимальный дизайн

- Проблема идентификации параметра

- Научное моделирование

- Статистическая проверка модели

- Парадокс Штейна

Заметки [ править ]

- ^ Shirangi, Mehrdad G .; Дурлофски, Луи Дж. (2016). «Общий метод выбора репрезентативных моделей для принятия решений и оптимизации в условиях неопределенности». Компьютеры и науки о Земле . 96 : 109–123. Bibcode : 2016CG ..... 96..109S . DOI : 10.1016 / j.cageo.2016.08.002 .

- ^ а б Дин, Джи; Тарох, Вахид; Ян, Юхун (2018). «Методы выбора модели: обзор» . Журнал обработки сигналов IEEE . 35 (6): 16–34. arXiv : 1810.09583 . DOI : 10.1109 / MSP.2018.2867638 . ISSN 1053-5888 . S2CID 53035396 .

- ^ Дин, Дж .; Тарох, В .; Ян, Ю. (июнь 2018 г.). «Соединение AIC и BIC: новый критерий авторегрессии» . IEEE Transactions по теории информации . 64 (6): 4024–4043. arXiv : 1508.02473 . DOI : 10.1109 / TIT.2017.2717599 . ISSN 1557-9654 . S2CID 5189440 .

Ссылки [ править ]

- Ах хорошо.; Derryberry, D .; Петерсон, Т. (2014), "Выбор модели для экологов: мировоззрении АИК и БИК", экологии , 95 (3): 631-636, DOI : 10,1890 / 13-1452.1 , PMID 24804445

- Акаике, Х. (1994), "Влияние информационной точки зрения на развитие статистической науки", Боздоган, Х. (ред.), Труды Первой конференции США / ЯПОНИИ по границам статистического моделирования: информационное Подход - Том 3 , Kluwer Academic Publishers , стр. 27–38.

- Андерсон, Д.Р. (2008), Модельно-ориентированный вывод в науках о жизни , Springer, ISBN 9780387740751

- Андо, Т. (2010), Выбор байесовской модели и статистическое моделирование , CRC Press , ISBN 9781439836156

- Бреймана, Л. (2001), "Статистическое моделирование: две культуры", Статистическая наука , 16 : 199-231, DOI : 10,1214 / сс / 1009213726

- Бернем, КП; Андерсон, Д. Р. (2002), Выбор модели и многомодельный вывод: практический теоретико-информационный подход (2-е изд.), Springer-Verlag, ISBN 0-387-95364-7[это более 38000 цитирований в Академии Google ]

- Чемберлин, Т.С. (1890), «Метод нескольких рабочих гипотез», Science , 15 (366): 92–6, Bibcode : 1890Sci .... 15R..92. , DOI : 10.1126 / science.ns-15.366.92 , PMID 17782687(перепечатано в 1965 г., Science 148: 754–759 [1] doi : 10.1126 / science.148.3671.754 )

- Клаескенс, Г. (2016), «Выбор статистической модели» (PDF) , Ежегодный обзор статистики и ее применения , 3 (1): 233–256, Bibcode : 2016AnRSA ... 3..233C , doi : 10.1146 / annurev -statistics-041715-033413[ постоянная мертвая ссылка ]

- Claeskens, G .; Хьорт, Н. Л. (2008), Выбор модели и усреднение модели , Cambridge University Press, ISBN 9781139471800

- Кокс, Д.Р. (2006), Принципы статистического вывода , Cambridge University Press

- Кашьяпа, RL (1982), "Оптимальный выбор AR и МЫ части в авторегрессионных моделях скользящей средних", IEEE Transactions на шаблон анализ и Machine Intelligence , IEEE, П-4 (2): 99-104, DOI : 10,1109 / TPAMI. 1982.4767213 , PMID 21869012 , S2CID 18484243

- Konishi, S .; Китагава, Г. (2008), Информационные критерии и статистическое моделирование , Springer, Bibcode : 2007icsm.book ..... K , ISBN 9780387718866

- Лахири П. (2001), Выбор модели , Институт математической статистики.

- Leeb, H .; Pötscher, BM (2009), «Выбор модели», в Anderson, TG (ed.), Handbook of Financial Time Series , Springer, pp. 889–925, doi : 10.1007 / 978-3-540-71297-8_39 , ISBN 978-3-540-71296-1

- Лукач, П.М. Томпсон, WL; Кендалл, Вашингтон; Гулд, WR; Доэрти, П. Ф. младший; Бернем, КП; Anderson, DR (2007), "Проблемы , касающиеся призыва к плюрализму теории информации и проверки гипотез", Журнал прикладной экологии , 44 (2): 456-460, DOI : 10.1111 / j.1365-2664.2006.01267.x

- Маккуорри, Аллан Д. Р.; Цай, Чи-Линг (1998), Выбор модели регрессии и временных рядов , Сингапур: World Scientific, ISBN 981-02-3242-X

- Массарт, П. (2007), Неравенства концентраций и выбор модели , Springer

- Массарт, П. (2014), «Неасимптотическое блуждание по вероятности и статистике» , в Lin, Xihong (ed.), Past, Present, and Future of Statistical Science , Chapman & Hall , pp. 309–321, ISBN. 9781482204988

- Наварро, DJ (2019), «Между дьяволом и глубоким синим морем: напряженность между научным суждением и выбором статистической модели», Computational Brain & Behavior , 2 : 28–34, doi : 10.1007 / s42113-018-0019-z

- Ресенде, Пауло Анджело Алвес; Дореа, Чанг Чунг Ю (2016), «Идентификация модели с использованием критерия эффективного определения», Журнал многомерного анализа , 150 : 229–244, arXiv : 1409.7441 , doi : 10.1016 / j.jmva.2016.06.002 , S2CID 5469654

- Шмуэли, Г. (2010), "Объяснить или предсказать?" , Статистическая наука , 25 (3): 289-310, Arxiv : 1101,0891 , DOI : 10,1214 / 10-STS330 , МР 2791669 , S2CID 15900983

- Wit, E .; van den Heuvel, E .; Romeijn, J.-W. (2012), " ' Все модели неправильны ...': введение в модели неопределенности" (PDF) , Statistica Neerlandica , 66 (3): 217-236, DOI : 10.1111 / j.1467-9574.2012.00530.x

- Wit, E .; McCullagh, P. (2001), Viana, MAG; Ричардс, Д. Сент-П. (ред.), "Расширяемость статистических моделей", Алгебраические методы в статистике и вероятности , стр. 327–340.

- Войтович, Анна; Bigaj, Tomasz (2016), «Обоснование, подтверждение и проблема взаимоисключающих гипотез», в Kuźniar, Adrian; Odrowąż-Sypniewska, Джоанна (ред . ), Раскрытие Факты и ценности , Brill издатели ., Стр 122-143, DOI : 10,1163 / 9789004312654_009 , ISBN 9789004312654

- Оуранг, Араш; Янссон, Магнус (2018), «Критерий выбора модели для многомерной линейной регрессии» , IEEE Transactions on Signal Processing , 66 (13): 3436–3446, Bibcode : 2018ITSP ... 66.3436O , doi : 10.1109 / TSP. 2018.2821628 , ISSN 1941-0476 , S2CID 46931136