Эта статья может быть слишком технической, чтобы ее могло понять большинство читателей . ( Октябрь 2010 г. ) ( Узнайте, как и когда удалить этот шаблон сообщения ) |

МЕТЕОР ( метрика для оценки перевода с явным упорядочиванием ) - это метрика для оценки результатов машинного перевода . Показатель основан на гармоническом среднем значении точности и отзыва униграмм , причем отзыв имеет больший вес, чем точность. Он также имеет несколько функций, которых нет в других показателях, таких как выделение основы и сопоставление синонимии , а также стандартное точное сопоставление слов. Метрика была разработана для устранения некоторых проблем, обнаруженных в более популярном BLEU.метрики, а также дают хорошую корреляцию с человеческим суждением на уровне предложения или сегмента. Это отличается от метрики BLEU тем, что BLEU ищет корреляцию на уровне корпуса.

Представлены результаты , которые дают корреляцию до 0,964 с человеческим суждением на уровне состава, по сравнению с BLEU достижения «s из 0,817 на тот же набор данных. На уровне предложения максимальная корреляция с человеческим суждением составила 0,403. [1]

Алгоритм [ править ]

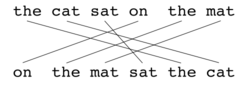

Как и в случае с BLEU , основной единицей оценки является предложение, алгоритм сначала создает выравнивание (см. Иллюстрации) между двумя предложениями , строкой перевода кандидата и строкой перевода ссылки. Выравнивания представляют собой набор отображений между юниграммами . Отображение можно представить как линию между униграммой в одной строке и униграммой в другой строке. Ограничения следующие: каждая униграмма в переводе кандидата должна соответствовать нулю или одной униграмме в ссылке. Сопоставления выбираются для выполнения выравнивания, как определено выше. Если есть два выравнивания с одинаковым количеством сопоставлений, выравнивание выбирается с наименьшим количеством сопоставлений.кресты , то есть с меньшим количеством пересечений двух отображений. Из двух показанных выравниваний в этой точке будет выбрано выравнивание (a). Этапы выполняются последовательно, и каждый этап добавляет к выравниванию только те униграммы, которые не были сопоставлены на предыдущих этапах. После того, как окончательное выравнивание вычислено, оценка рассчитывается следующим образом: Точность униграммы P рассчитывается как:

| Модуль | Кандидат | Справка | Матч |

|---|---|---|---|

| Точный | Хорошо | Хорошо | да |

| Стеммер | Товары | Хорошо | да |

| Синонимия | хорошо | Хорошо | да |

Где m - количество униграммов в переводе-кандидате, которые также встречаются в справочном переводе, и - количество униграммов в переводе-кандидате. Воспроизведение униграммы R вычисляется как:

Где m такое же, как указано выше, и представляет собой количество униграмм в справочном переводе. Точность и отзыв сочетаются с использованием среднего гармонического значения следующим образом, причем отзыв в 9 раз превышает точность:

Меры, которые были введены до сих пор, учитывают совпадение только в отношении отдельных слов, но не в отношении более крупных сегментов, которые появляются как в ссылке, так и в предложении-кандидате. Чтобы учесть это, для вычисления штрафа p за выравнивание используются более длинные совпадения в n -граммах . Чем больше отображений, которые не являются смежными в ссылке и предложении-кандидате, тем выше будет штраф.

Чтобы вычислить этот штраф, униграммы группируются в наименьшее возможное количество фрагментов , где фрагмент определяется как набор униграмм, которые являются смежными в гипотезе и в ссылке. Чем длиннее соседние сопоставления между кандидатом и ссылкой, тем меньше фрагментов. Перевод, идентичный справочнику, даст только один фрагмент. Штраф p вычисляется следующим образом:

Где c - количество фрагментов, а - количество отображаемых униграмм. Окончательная оценка сегмента рассчитывается как M ниже. Штраф имеет эффект уменьшения до 50%, если нет биграмм или более длинных совпадений.

Чтобы вычислить оценку по всему корпусу или набору сегментов, берутся совокупные значения для P , R и p , а затем объединяются с использованием той же формулы. Алгоритм также работает для сравнения перевода кандидата с более чем одним справочным переводом. В этом случае алгоритм сравнивает кандидата с каждой из ссылок и выбирает наивысший балл.

Примеры [ править ]

| Справка | в | Кот | сидел | на | в | мат |

| Гипотеза | на | в | мат | сидел | в | Кот |

Оценка: 0,5000 = Fср .: 1,0000 × (1 - Штраф: 0,5000)Fmean: 1.0000 = 10 × Точность: 1.0000 × Отзыв: 1.0000 / (Отзыв: 1.0000 + 9 × Точность: 1.0000)Штраф: 0,5000 = 0,5 × (фрагментация: 1,0000 ^ 3)Фрагментация: 1.0000 = Чанки: 6.0000 / совпадения: 6.0000

| Справка | в | Кот | сидел | на | в | мат |

| Гипотеза | в | Кот | сидел | на | в | мат |

Оценка: 0,9977 = Fср .: 1,0000 × (1 - Штраф: 0,0023)Fmean: 1.0000 = 10 × Точность: 1.0000 × Отзыв: 1.0000 / (Отзыв: 1.0000 + 9 × Точность: 1.0000)Штраф: 0,0023 = 0,5 × (фрагментация: 0,1667 ^ 3) Фрагментация: 0,1667 = Чанки: 1,0000 / совпадения: 6,0000

| Справка | в | Кот | сидел | на | в | мат | |

| Гипотеза | в | Кот | было | сидел | на | в | мат |

Оценка: 0,9654 = Fср .: 0,9836 × (1 - Штраф: 0,0185)Fmean: 0,9836 = 10 × Точность: 0,8571 × Напоминание: 1,0000 / (Напоминание: 1,0000 + 9 × Точность: 0,8571)Штраф: 0,0185 = 0,5 × (фрагментация: 0,3333 ^ 3)Фрагментация: 0,3333 = Чанки: 2,0000 / совпадения: 6,0000

См. Также [ править ]

- BLEU

- F-мера

- NIST (метрическая система)

- ROUGE (метрическая система)

- Коэффициент ошибок в словах (WER)

- Разделение словосочетаний на существительное

Заметки [ править ]

- Перейти ↑ Banerjee, S. and Lavie, A. (2005)

Ссылки [ править ]

- Банерджи, С. и Лави, А. (2005) «МЕТЕОР: автоматическая метрика для оценки машинного обучения с улучшенной корреляцией с человеческими суждениями» в материалах семинара по внутренним и внешним мерам оценки для машинного обучения и / или обобщению на 43-м ежегодном совещании Ассоциация компьютерной лингвистики (ACL-2005), Анн-Арбор, Мичиган, июнь 2005 г.

- Лави, А., Сагае, К. и Джаяраман, С. (2004) «Значение отзыва в автоматических показателях для оценки MT» в Proceedings of AMTA 2004, Вашингтон, округ Колумбия. Сентябрь 2004 г.

Внешние ссылки [ править ]

- Система оценки автоматического машинного перевода METEOR (включая ссылку для загрузки)